关于Trea+MCP协议使用教程

前两个标题部分为mcp部分介绍,如果想了解Trea和mcp的使用,请空降至第三小节

MCP 协议通过标准化 AI 智能体与外部资源的连接,显著提升了智能体的上下文感知能力和任务执行效率。在国内,MCP 在企业自动化、物联网和开发社区中展现出巨大潜力,尽管仍需克服认知度和本地化挑战。随着生态系统的扩展和与其他协议的协同,MCP 有望成为智能体互联网的基石,驱动 AI 应用的下一波创新。

一、MCP协议简介

Model Context Protocol (MCP) 是一种由 Anthropic 于 2024 年 11 月开源的标准化协议,旨在为大型语言模型(LLMs)和智能体(AI Agents)提供统一的接口,以连接外部数据源、工具和系统。MCP 的出现是为了解决传统 AI 模型与外部资源整合的复杂性和碎片化问题。传统上,开发人员需要为每个数据源或工具(如数据库、API、企业系统)编写定制代码,导致集成效率低下且难以扩展。MCP 通过定义标准化的通信方式,类似“AI 的 USB-C 端口”,使智能体能够动态访问多样化的外部上下文,从而实现更智能、上下文感知的响应和操作。

MCP 的核心目标是增强智能体的“行动能力”(agentic capability),使其不仅能回答问题,还能执行复杂任务,如查询数据库、操作文件系统、调用 API 或协调多工具工作流。MCP 的开源性质吸引了广泛的社区参与,企业和开发者通过构建 MCP 服务器(MCP Servers)扩展了其生态系统,覆盖了 Google Drive、Slack、GitHub、Postgres 等企业系统。截至 2025 年初,MCP 已成为 AI 领域热门话题,社区贡献了超过 4000 个 MCP 服务器,标志着其快速发展和广泛接受。

二、底层原理简介

MCP 采用客户端-服务器架构,通过标准化的协议实现 AI 智能体与外部资源的高效交互。以下是其底层原理的简要说明:

组件:

MCP 主机(Host):运行智能体的应用程序(如 Claude Desktop、IDE),负责发起请求并协调工作流。

MCP 客户端(Client):位于主机与服务器之间,管理实时数据交换和协议翻译。

MCP 服务器(Server):暴露特定功能(如 API、数据库、文件系统)的轻量级程序,提供工具、上下文和提示(prompts)。

数据源:包括本地资源(如文件、数据库)和远程服务(如云 API)。

工作流程:

工具发现:主机查询服务器获取可用工具列表(如天气 API、文件操作)。

上下文注入:主机将用户请求和工具信息发送给 LLM,LLM 决定使用哪些工具。

请求执行:客户端通过 MCP 协议向服务器发送结构化请求,服务器执行操作并返回结果。

实时交互:MCP 支持双向通信(类似 WebSocket),允许动态上下文更新和多步骤工作流。

关键特性:

标准化:MCP 定义统一的工具调用和数据格式(如 JSON),消除自定义集成的复杂性。

动态发现:智能体可动态识别新工具,无需硬编码。

安全性:通过 TLS 加密、JWT 认证和命名空间隔离确保数据安全。

可扩展性:支持添加新服务器,类似插件机制,适应多样化需求。

与 LLM 的协作:

MCP 将外部上下文(如数据库查询结果)作为增强提示(augmented prompt)注入 LLM,使其生成更准确的响应。

智能体通过工具调用(tool calls)与服务器交互,执行操作后将结果反馈给 LLM,形成闭环工作流。

示例:

假设用户请求“查询当前天气”:

主机(聊天应用)通过 MCP 客户端查询天气 API 服务器。

服务器返回天气数据,LLM 基于此生成自然语言响应。

整个过程通过 MCP 协议标准化,无需为天气 API 编写专用代码。

MCP 的设计灵感来源于语言服务器协议(LSP),但更强调智能体的自主性和多工具协作,适合构建复杂的工作流。

三、Trea+MCP操作教程

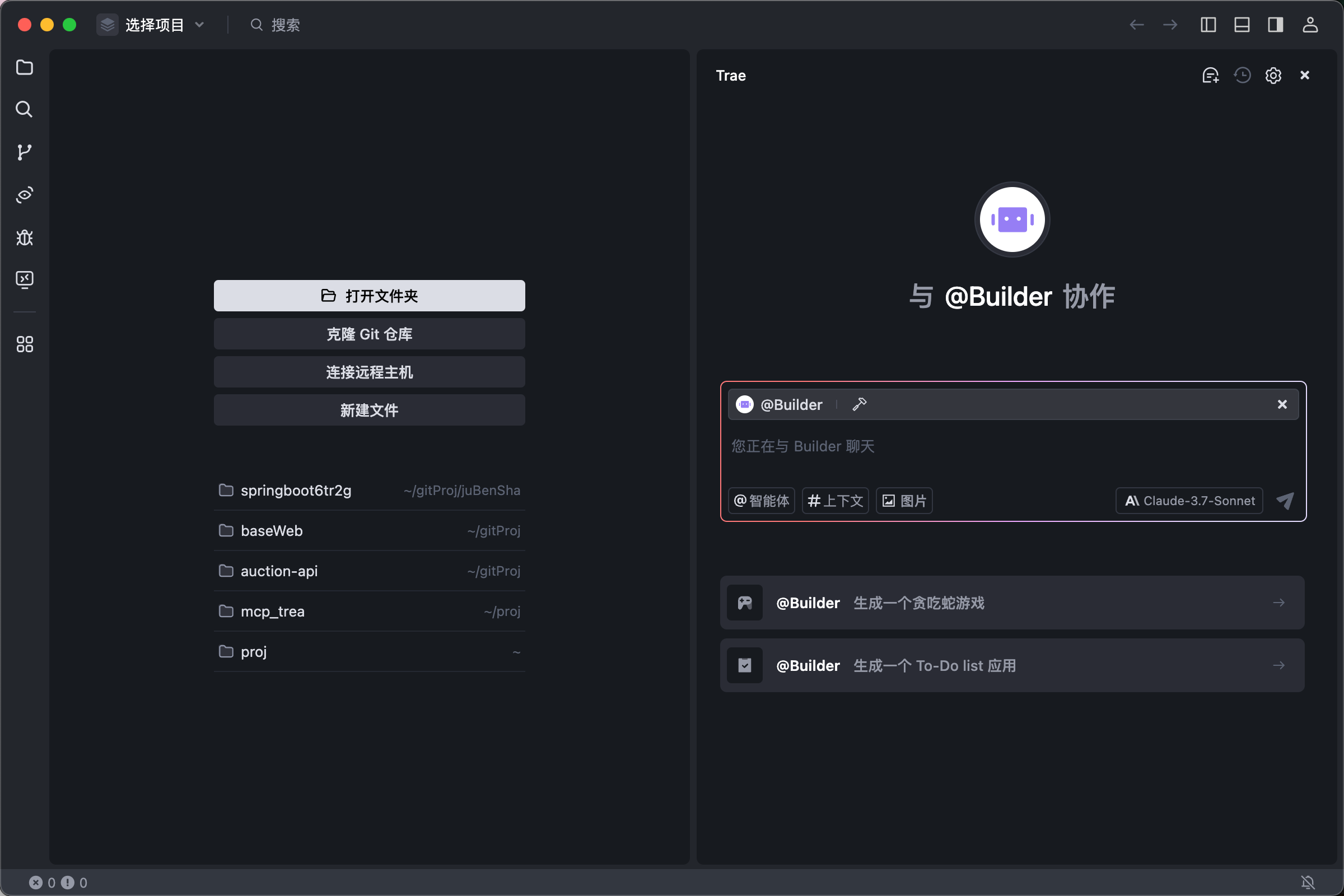

首先,目前比较火的是cursor,但说实话,不是每个人都有条件去使用cursor的,我们把目光转移到字节的trea中,他可以使用国内的deepseek 豆包等模型,也可以使用国外的gpt或者claude模型(国外模型需要下载国外版的trea,地址:https://www.trae.ai/)。请注意,国外部分模型可能会需要排队,但是他免费~;

1、安装Trea

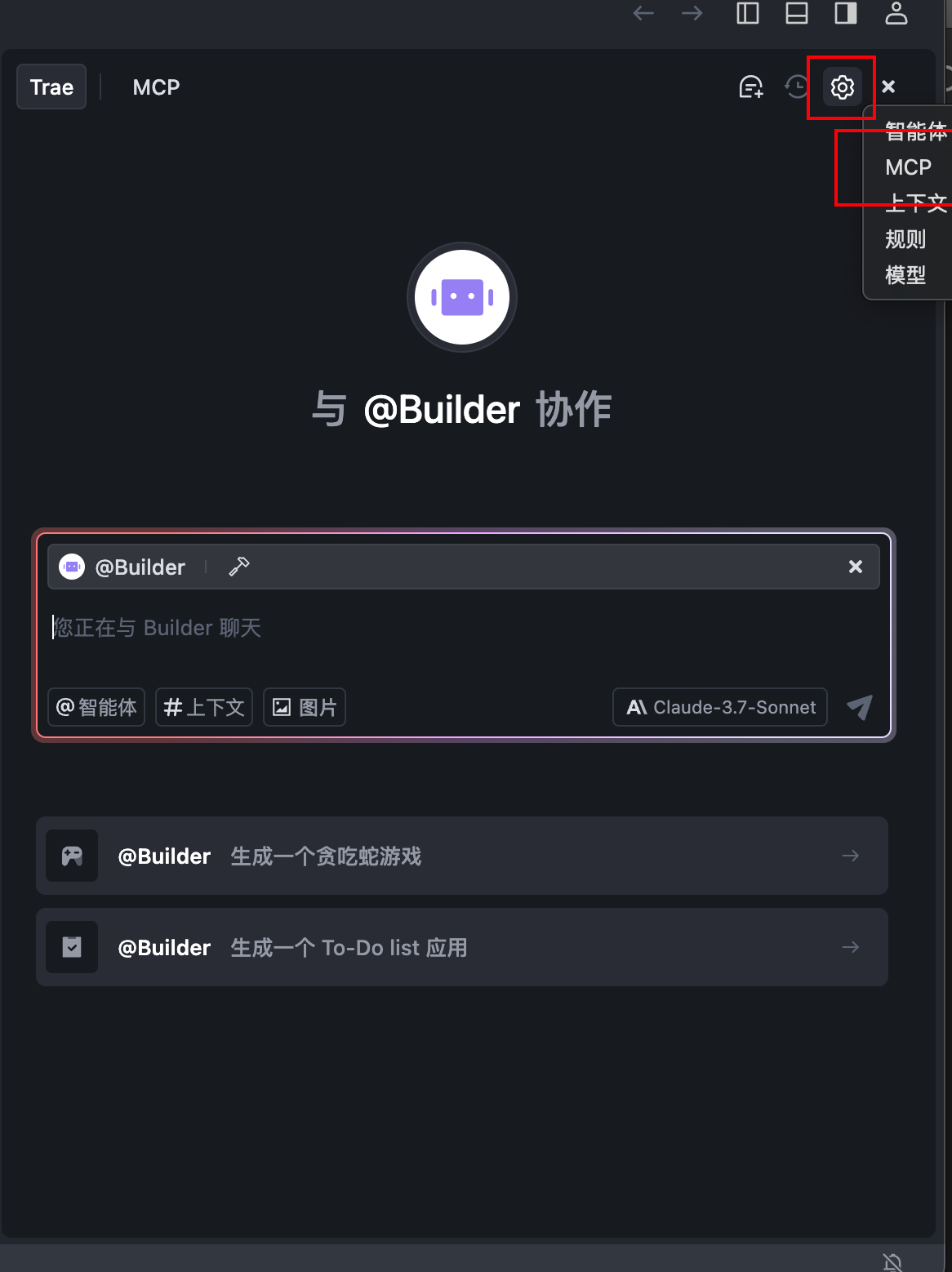

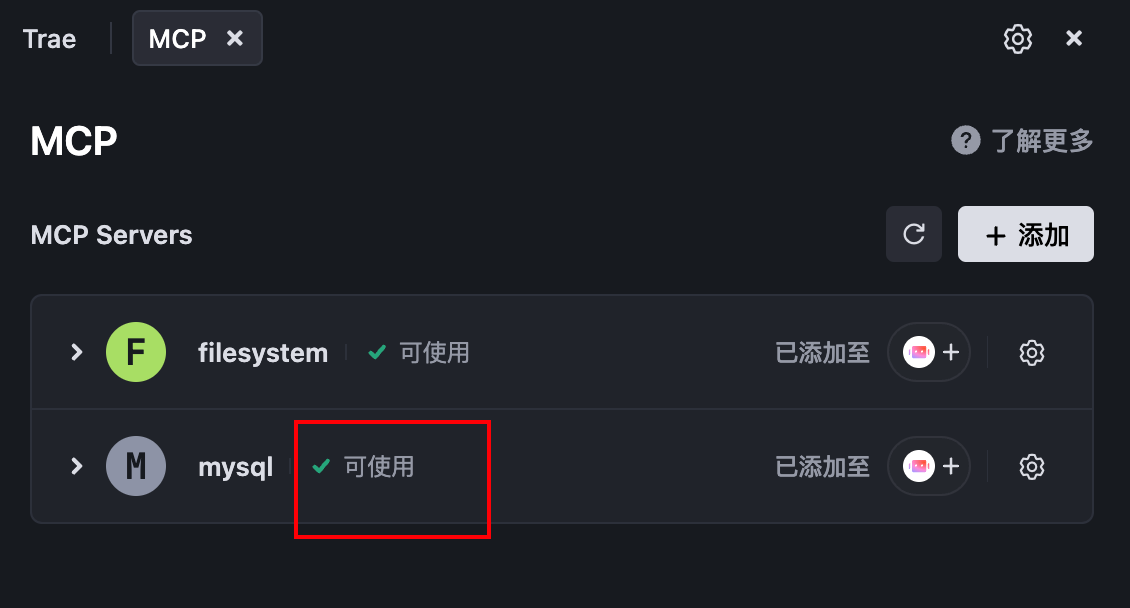

2、点击右上角设置中的mcp服务

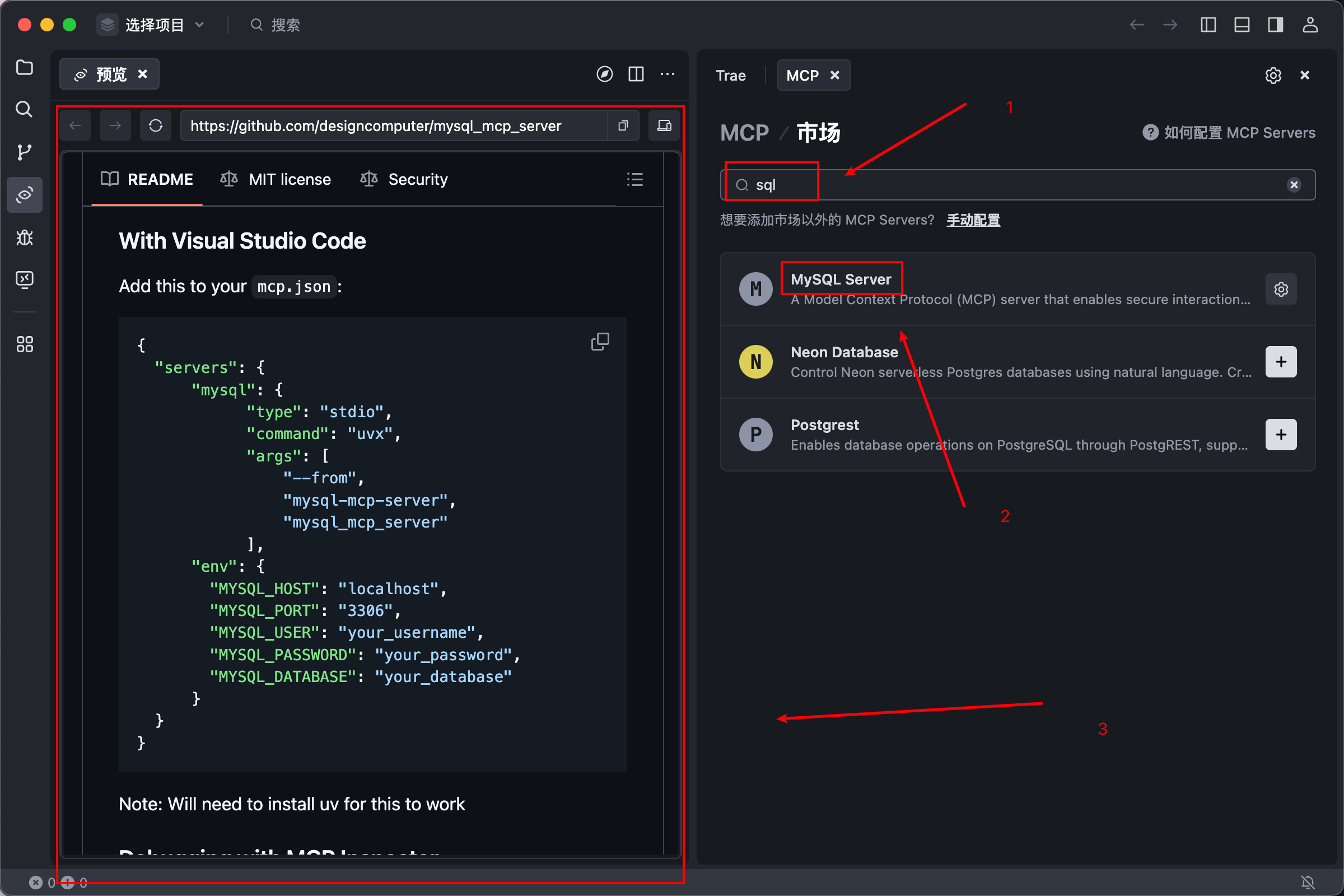

3、点击添加后,可以发现内置了许多mcp的服务,这些服务都是可以直接使用的,我们以mysql服务为例

然后我们注意一下,点击mcp服务后跳转的github网址(这个需要magic),这里面有一个command 他这里填写的是uvx,这里说一下uvx和npx的区别,前者是基于python的,后者是基于nodejs的,至于python的uvx如何安装,本文中不过多赘述,使用nodejs的npx,只需要拥有node等正常前端开发环境就可以了!

然后需要注意的是,我们在github中选择的是With Visual Studio Code

因为无论是trea 还是 cursor 都是基于vscode的二开。所以我们使用这个json

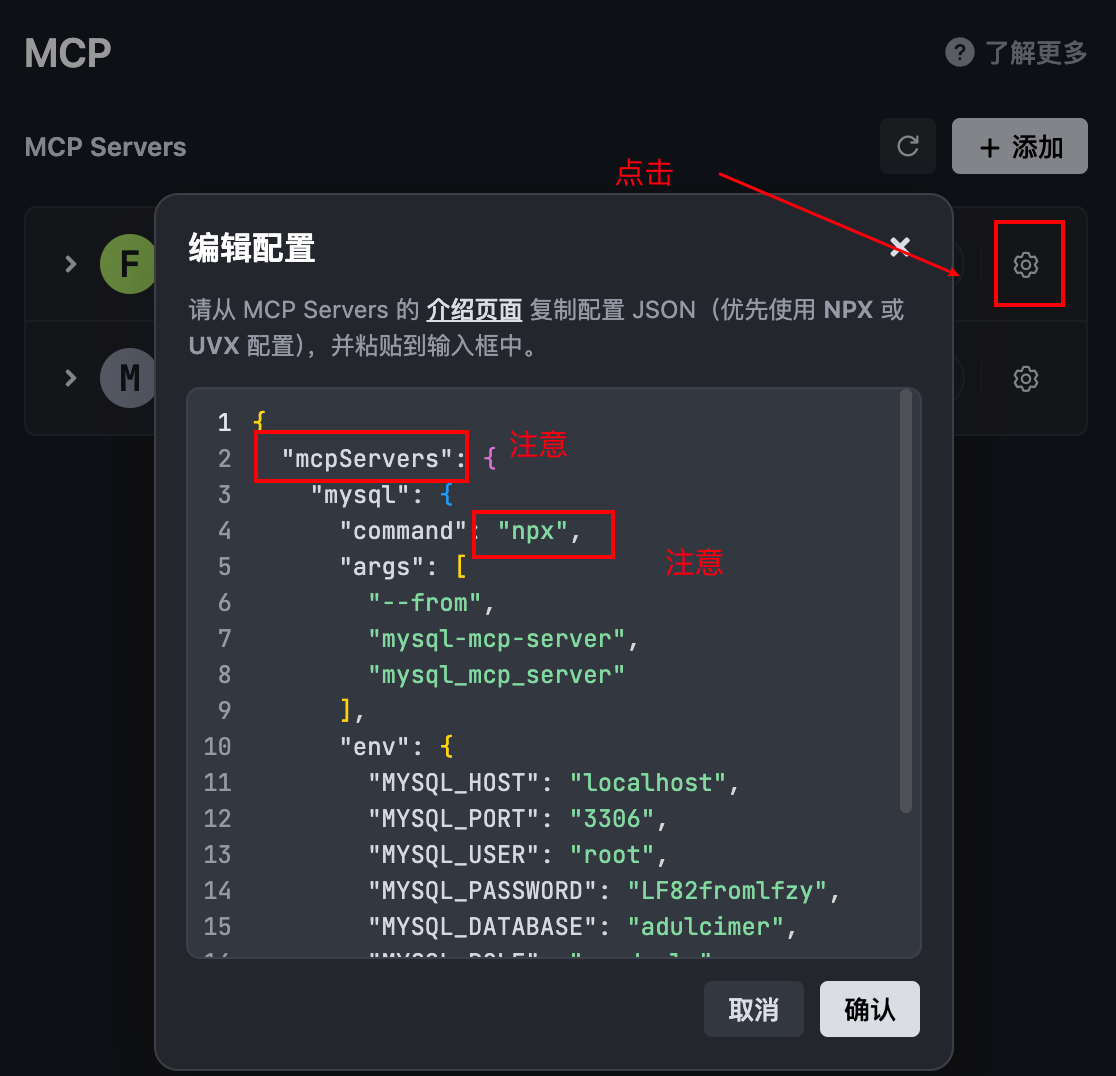

4、将json复制进入mcp服务

注意我们在这里把它改为npx,也就是使用node版本的mcp。

还有一点,我们的json头要用mcpServers,这个应该是trea的语法,不改会报错

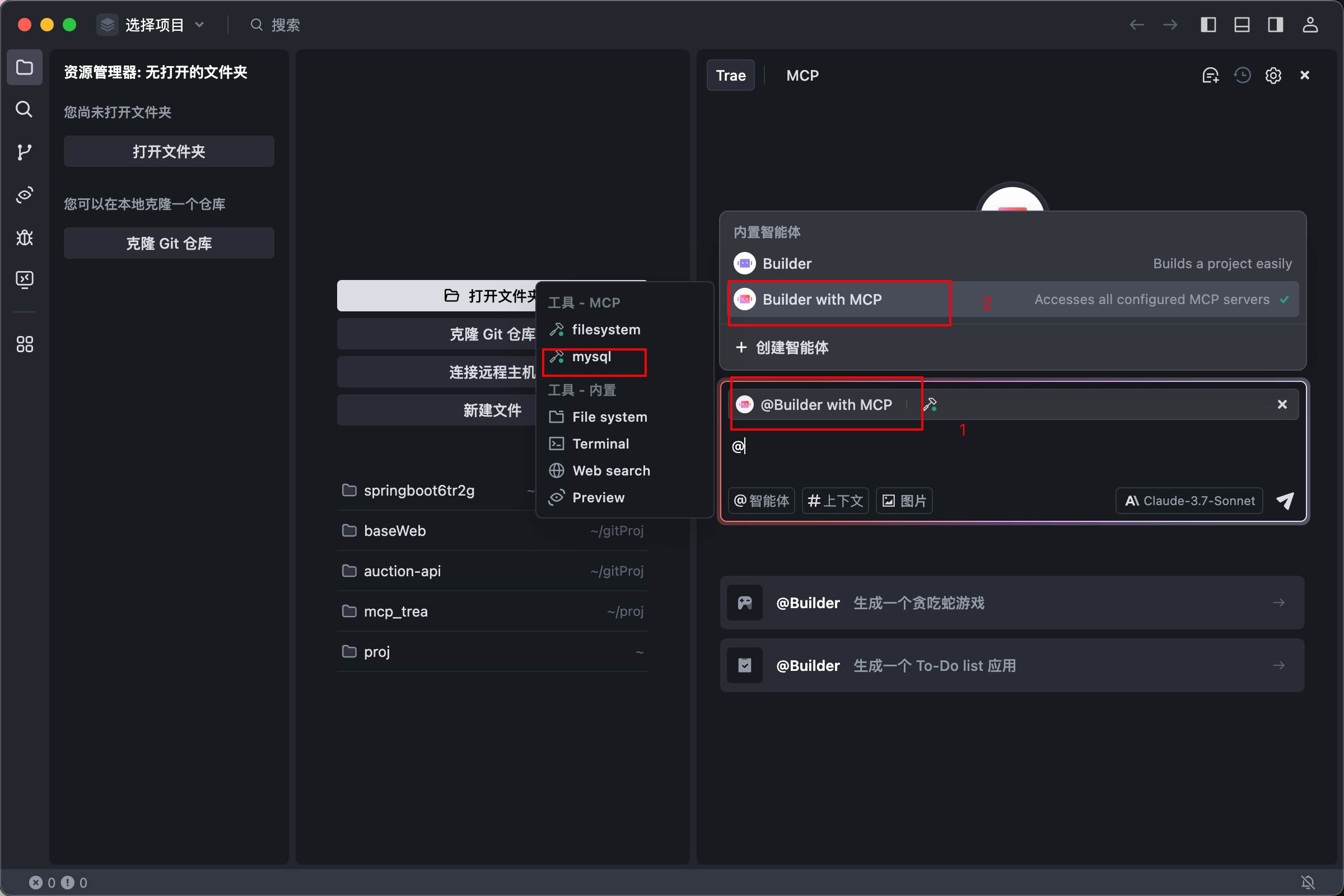

5、在智能体聊天框中测试

我们选择智能体时选择mcp智能体;

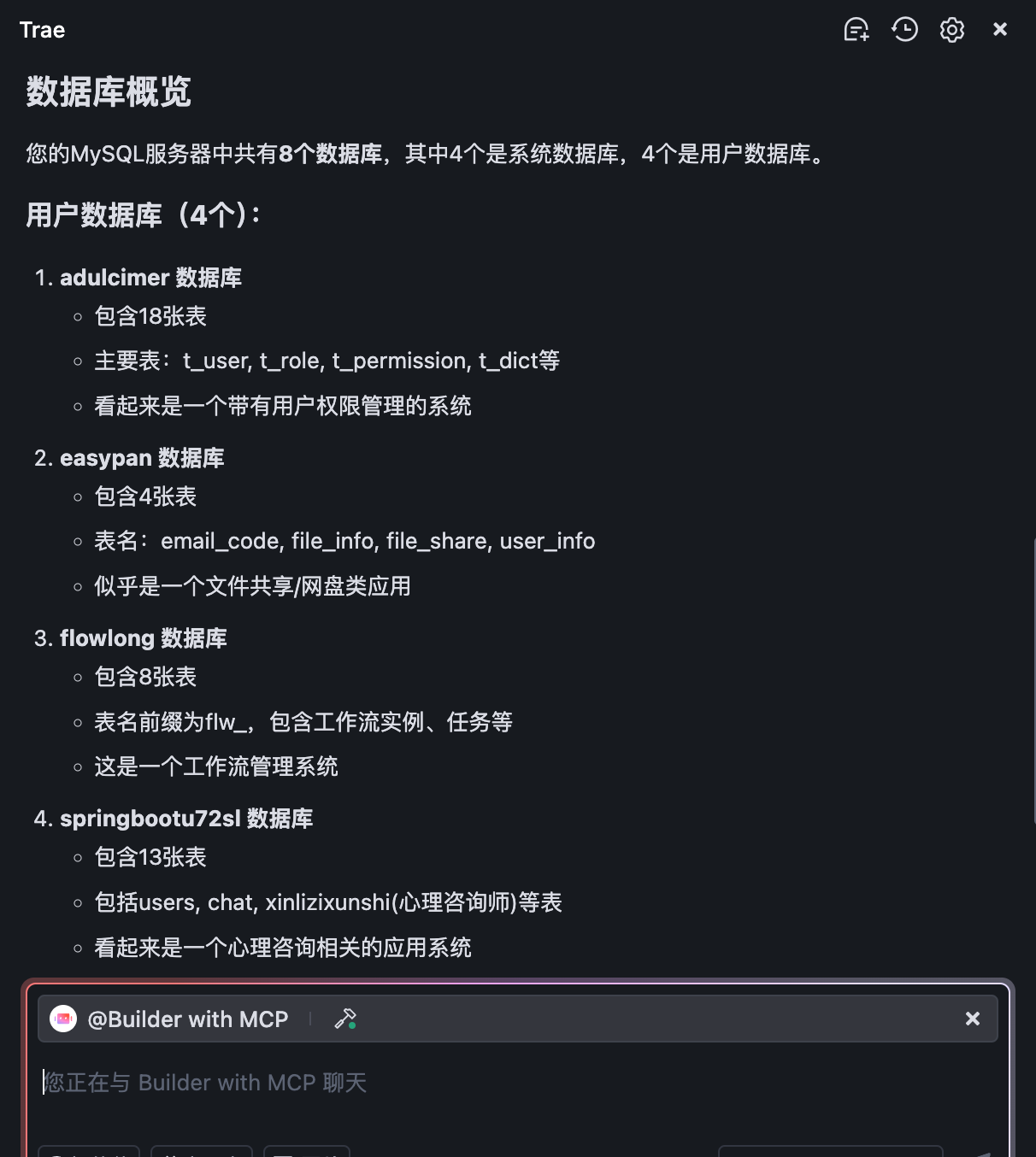

然后输入我们的要求

好,我们目前已经实现了让大模型接入我们本地服务,那么我们可以通过json中的配置赋予ai模型不同的权限,让他们进行crud或者参考开发等等;

6、拓展,多个mcp服务

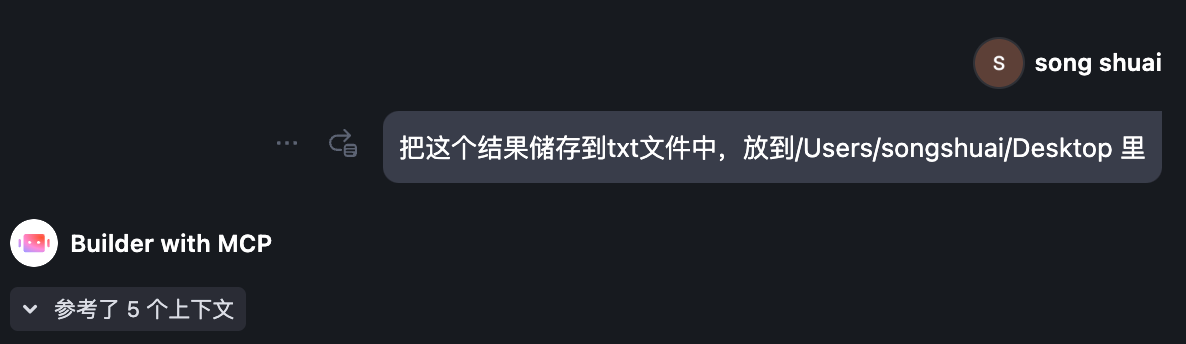

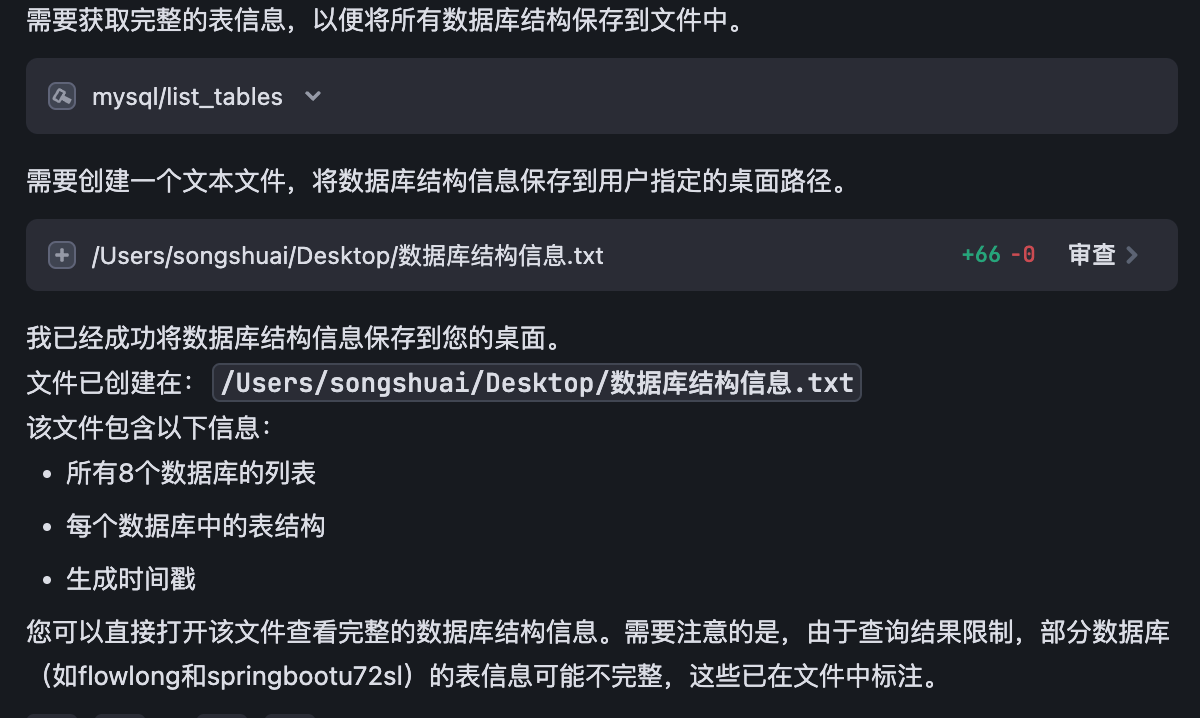

我们可以用其他mcp进行组合,让我们的工作效率提高,比如,我本地也装了一个file 的mcp,他的作用是让智能体拥有在我们电脑中进行文件操作的权限,那么我们就可以要求ai模型在我们电脑的特定位置生成一些文件,

我们来打个比方,让他帮我们把生成的数据库文件写入到txt中,并放在我们的桌面